Bestemmelseskoefficient - Coefficient of determination

I statistik er bestemmelseskoefficienten , også stavet koëfficient , betegnet R 2 eller r 2 og udtales "R i kvadrat", andelen af variationen i den afhængige variabel, der er forudsigelig ud fra den eller de uafhængige variabler.

Det er en statistik, der bruges i forbindelse med statistiske modeller, hvis hovedformål enten er forudsigelse af fremtidige resultater eller test af hypoteser på grundlag af andre relaterede oplysninger. Det giver et mål for, hvor godt observerede resultater replikeres af modellen, baseret på andelen af den totale variation af resultater forklaret af modellen.

Der er flere definitioner af R 2 , der kun undertiden er ækvivalente. En klasse af sådanne tilfælde omfatter den af simpel lineær regression , hvor r 2 anvendes i stedet for R 2 . Når kun et skæringspunkt er inkluderet, så r 2 er simpelthen kvadratet af prøven korrelationskoefficienten (dvs. r ) mellem de observerede resultater og de observerede prædiktor værdier. Hvis yderligere regressorer er inkluderet, R 2 er kvadratet på koefficient af multipel korrelation . I begge sådanne tilfælde ligger bestemmelseskoefficienten normalt fra 0 til 1.

Der er tilfælde, hvor den beregningsmæssige definitionen af R 2 kan give negative værdier, afhængigt af den definition, der anvendes. Dette kan opstå, når de forudsigelser, der bliver sammenlignet med de tilsvarende resultater, ikke er afledt af en modelpassende procedure ved hjælp af disse data. Selv om der er anvendt en model-fitting procedure, R 2 kan stadig være negativ, for eksempel når lineær regression udføres uden at medtage et skæringspunkt, eller når en ikke-lineær funktion anvendes til at tilpasse dataene. I tilfælde, hvor der opstår negative værdier, giver middelværdien af dataene en bedre tilpasning til resultaterne end de tilpassede funktionsværdier i henhold til dette særlige kriterium.

En artikel, der blev offentliggjort i PeerJ Computer Science -tidsskriftet i 2021, siger, at bestemmelseskoefficienten kan være mere sandfærdig end SMAPE , MAE , MAPE , MSE og RMSE i regressionsanalyseevaluering .

Ved evalueringen af goodness-of-fit simuleret ( Y pred ) vs. målt ( Y obs ) værdier, er det ikke hensigtsmæssigt at basere dette på R 2 for den lineære regression (dvs. Y obs = m · Y pred + b ). Den R 2 kvantificerer graden af enhver lineær korrelation mellem Y obs og Y pred , mens for goodness-of-fit evaluering bør tages kun en specifik lineær korrelation i betragtning: Y obs = 1 · Y pred + 0 (dvs. 1: 1 linje).

Definitioner

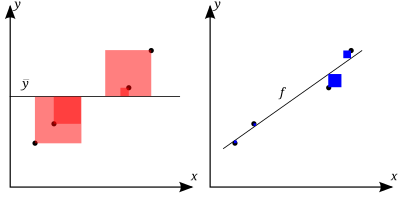

Jo bedre den lineære regression (til højre) passer til dataene i forhold til det simple gennemsnit (på den venstre graf), jo tættere er værdien af 1. Arealerne af de blå firkanter repræsenterer de kvadrerede rester i forhold til den lineære regression. Arealerne af de røde firkanter repræsenterer de kvadrerede rester i forhold til gennemsnitsværdien.

Et datasæt har n -værdier mærket y 1 , ..., y n (samlet kendt som y i eller som en vektor y = [ y 1 , ..., y n ] T ), hver forbundet med en monteret (eller modelleret , eller forudsagt) værdi f 1 , ..., f n (kendt som f i , eller undertiden ŷ i , som en vektor f ).

Definer resterne som e i = y i - f i (danner en vektor e ).

Hvis er middelværdien af de observerede data:

derefter kan datasættets variabilitet måles med to summer af kvadrater formler:

- Summen af kvadrater af rester, også kaldet den resterende sum af firkanter :

- Den samlede sum af firkanter (proportional med variansen af dataene):

Den mest generelle definition af bestemmelseskoefficienten er

I bedste tilfælde matcher de modellerede værdier nøjagtigt de observerede værdier, hvilket resulterer i og . En baseline model, som altid forudsiger , vil have . Modeller, der har dårligere forudsigelser end denne baseline, vil have en negativ .

Forholdet til uforklarlig varians

I generel form, R 2 kan ses at være relateret til den del af varians ikke forklares (FVU), idet det andet udtryk sammenligner uforklaret varians (varians af modellens fejl) med den samlede varians (af data):

Som forklaret varians

Antag R 2 = 0,49. Dette indebærer, at der er redegjort for 49% af variabiliteten af den afhængige variabel i datasættet, og de resterende 51% af variablen er stadig ikke redegjort for. For regressionsmodeller defineres regressionssummen for kvadrater, også kaldet den forklarede sum af firkanter , som

I nogle tilfælde, som ved simpel lineær regression , er den samlede sum af kvadrater lig med summen af de to andre summer af firkanter defineret ovenfor:

Se Partitionering i den generelle OLS -model for en afledning af dette resultat for et tilfælde, hvor forholdet holder. Når dette forhold gør hold, den ovennævnte definition af R 2 er ækvivalent med

hvor n er antallet af observationer (tilfælde) på variablerne.

I denne form R 2 er udtrykt som forholdet mellem den forklarede varians (varians af modellens forudsigelser, som er SS reg / n ) til den samlede varians (stikprøvevariansen for den afhængige variable, der er SS tot / n ).

Denne opdeling af summen af kvadrater gælder for eksempel når modelværdierne ƒ i er opnået ved lineær regression . En mildere tilstrækkelig tilstand lyder som følger: Modellen har formen

hvor q i er vilkårlige værdier, der måske eller måske ikke afhænger af i eller af andre frie parametre (det almindelige valg q i = x i er kun et specielt tilfælde), og koefficienten estimerer og opnås ved at minimere den resterende sum af kvadrater .

Dette sæt betingelser er vigtigt, og det har en række implikationer for egenskaberne af de monterede rester og de modellerede værdier. Især under disse betingelser:

Som kvadratisk korrelationskoefficient

I lineær mindste kvadraters multipel regression med en anslået udtryk for skæringspunktet, R 2 er lig med kvadratet på Pearson korrelationskoefficienten mellem de observerede og modellerede (forventede) dataværdier for den afhængige variabel.

I en lineær mindste kvadraters regression med et skæringspunkt og en enkelt forklarer er dette også lig med den kvadrerede Pearson -korrelationskoefficient for den afhængige variabel og forklarende variabel

Det skal ikke forveksles med korrelationskoefficienten mellem to skøn, defineret som

hvor kovariansen mellem to koefficientestimater samt deres standardafvigelser er hentet fra covariansmatrixen for koefficientestimaterne.

Under mere generelle modellering forhold, hvor de forudsagte værdier kunne genereres fra en model forskellig fra lineær mindste kvadraters regression, en R 2 kan værdien beregnes som kvadratet på korrelationskoefficienten mellem de oprindelige og modellerede dataværdier. I dette tilfælde er værdien ikke direkte et mål for, hvor gode de modellerede værdier er, men derimod et mål for, hvor god en forudsigelse kan konstrueres ud fra de modellerede værdier (ved at oprette en revideret forudsigelse af formen α + βƒ i ). Ifølge Everitt er denne brug specifikt definitionen af udtrykket "koefficient for bestemmelse": kvadratet af korrelationen mellem to (generelle) variabler.

Fortolkning

R 2 er en statistik, der vil give nogle oplysninger om godheden i en model. I regression, den R 2 determinationskoefficienten er et statistisk mål for hvor godt regression forudsigelser tilnærme de reelle datapunkter. En R 2 på 1 angiver, at regression forudsigelser perfekt passer til dataene.

Værdier af R 2 uden for området 0 til 1 kan opstå, når modellen passer til data værre end en horisontal hyperplan. Dette ville forekomme, når den forkerte model blev valgt, eller nonsensiske begrænsninger blev anvendt ved en fejl. Hvis ligning 1 af Kvålseth anvendes (dette er den anvendte ligning oftest), R 2 kan være mindre end nul. Hvis ligning 2 for Kvålseth bruges, kan R 2 være større end én.

I alle tilfælde, hvor R 2 er anvendt, er prædiktorer beregnet ved almindelig mindste kvadraters regression: det er, ved at minimere SS res . I dette tilfælde stiger R 2, når antallet af variabler i modellen øges ( R 2 er monoton stigende med antallet af variabler inkluderet - det vil aldrig falde). Dette illustrerer en ulempe ved en mulig anvendelse af R 2 , hvor man kan blive ved med at tilføje variabler ( køkkenvaskregression ) for at øge R 2 -værdien. For eksempel, hvis man forsøger at forudsige salget af en bilmodel ud fra bilens gasmængde, pris og motorkraft, kan man inkludere sådanne irrelevante faktorer som det første bogstav i modelnavnet eller højden på den ledende ingeniør, der designer bilen, fordi R 2 aldrig vil falde, da variabler tilføjes og sandsynligvis vil opleve en stigning på grund af tilfældighederne alene.

Dette fører til den alternative fremgangsmåde at se på justerede R 2 . Forklaringen på denne statistik er næsten det samme som R 2 , men det straffer statistikken som ekstra variable er inkluderet i modellen. For andre tilfælde end montering med almindelige mindst kvadrater kan R 2 -statistikken beregnes som ovenfor og kan stadig være et nyttigt mål. Hvis montering er af vægtede mindste kvadraters eller generaliserede mindste kvadrater , alternative versioner af R 2 kan beregnes i forhold til disse statistiske rammer, mens "rå" R 2 stadig kan være nyttig, hvis den er lettere fortolket. Værdier for R 2 kan beregnes for enhver form for prædiktiv model, som ikke behøver have et statistisk grundlag.

I en multipel lineær model

Overvej en lineær model med mere end en enkelt forklarende variabel af formen

hvor, for i th tilfælde er svaret variable, er p regressorer, og er en middelværdi nul fejl sigt. Mængderne er ukendte koefficienter, hvis værdier anslås med mindst kvadrater . Bestemmelseskoefficienten R 2 er et mål for modellens globale pasform. Specifikt R 2 er et element af [0, 1] og repræsenterer andelen af variabilitet i Y i , der kan tilskrives nogle lineær kombination af regressorer ( forklarende variabler ) i X .

R 2 tolkes ofte som andelen af respons variation "forklarede" af regressorer i modellen. Således angiver R 2 = 1, at den tilpassede model forklarer al variabilitet i , mens R 2 = 0 ikke angiver noget 'lineært' forhold (for retlinjeregression betyder det, at modellen med lige linje er en konstant linje (hældning = 0, skæringspunkt) = ) mellem responsvariablen og regressorer). En indre værdi, såsom R 2 = 0,7 kan fortolkes som følger: "Halvfjerds procent af variansen i responsvariabel kan forklares med de forklarende variable De resterende tredive procent kan tilskrives ukendt, lurer variabler . Eller iboende variabilitet"

En forsigtighed, der gælder for R 2 , som for andre statistiske beskrivelser af korrelation og association, er, at " korrelation ikke indebærer årsagssammenhæng ." Med andre ord, selvom korrelationer undertiden kan give værdifulde spor til afdækning af årsagssammenhænge mellem variabler, er en ikke-nul estimeret korrelation mellem to variabler ikke i sig selv et bevis på, at ændring af værdien af en variabel ville resultere i ændringer i værdierne for andre variabler. For eksempel er praksis med at bære tændstikker (eller en lighter) korreleret med forekomsten af lungekræft, men at bære tændstikker forårsager ikke kræft (i standardbetydningen "årsag").

I tilfælde af en enkelt regressor, monteret af mindste kvadraters, R 2 er kvadratet på Pearsons korrelation relatere regressor og svaret variabel. Mere generelt, R 2 er kvadratet af korrelationen mellem den beregnede prædiktor og svaret variabel. Med mere end én regressor kan R 2 betegnes som koefficienten for multipel bestemmelse .

Inflation af R 2

I mindste kvadraters regression ved anvendelse typiske data, R 2 er i det mindste svagt stigende med stigninger i antallet af regressorer i modellen. Fordi stigninger i antallet af regressorer øge værdien af R 2 , R 2 alene kan ikke anvendes som en meningsfuld sammenligning af modeller med meget forskellige antal uafhængige variable. For en meningsfuld sammenligning mellem to modeller kan der udføres en F-test på den resterende sum af kvadrater , svarende til F-testene i Granger-kausalitet , selvom dette ikke altid er passende. Som en påmindelse om dette, nogle forfattere betegner R 2 ved R q 2 , hvor q er antallet af kolonner i X (antallet af explanators herunder konstant).

For at demonstrere denne egenskab skal du først huske på, at målet med mindste kvadraters lineær regression er

hvor X i er en rækkevektor med værdier af forklarende variabler for tilfælde i og b er en kolonnevektor med koefficienter for de respektive elementer i X i .

Den optimale værdi af målsætningen er svagt mindre som flere forklarende variable tilsættes, og dermed yderligere søjler af (den forklarende data matrix, hvis jeg th række er X i ) tilsættes, af, at mindre begrænset minimering fører til en optimal omkostninger, hvilket er svagt mindre end mere begrænset minimering gør. I betragtning af den tidligere konklusion og at bemærke, at kun afhænger y , den ikke-faldende egenskab ved R 2 følger direkte fra definitionen ovenfor.

Den intuitive årsag til, at brug af en yderligere forklarende variabel ikke kan sænke R 2 er denne: Minimering svarer til at maksimere R 2 . Når den ekstra variabel er inkluderet, dataene har altid mulighed for at give det en estimeret koefficient på nul, hvorefter de forudsagte værdier og R 2 uændret. Den eneste måde, optimeringsproblemet vil give en koefficient på nul, er, hvis det forbedrer R 2 .

Advarsler

R 2 angiver ikke, om:

- de uafhængige variabler er en årsag til ændringerne i den afhængige variabel ;

- udeladt variabel bias eksisterer;

- den korrekte regression blev brugt;

- det mest passende sæt af uafhængige variabler er valgt;

- der er kollinearitet til stede i dataene om de forklarende variabler;

- modellen kan forbedres ved at bruge transformerede versioner af det eksisterende sæt uafhængige variabler;

- der er nok datapunkter til at drage en solid konklusion.

Udvidelser

Justeret R 2

Anvendelsen af en justeret R 2 (én fælles notation , udtales "R bar kvadreret", en anden er eller ) er et forsøg på at redegøre for fænomenet med R 2 automatisk og spuriously stigende når ekstra forklarende variabler sættes til modellen. Der er mange forskellige måder at justere på (se en oversigt). Langt den mest anvendte, til det punkt, at den typisk bare kaldes justeret R , er den korrektion, der er foreslået af Mordecai Ezekiel . Den justerede R 2 (ifølge Ezekiel) defineres som

hvor p er det samlede antal forklarende variabler i modellen (ikke inklusive det konstante udtryk), og n er stikprøvestørrelsen. Det kan også skrives som:

hvor df t er frihedsgraderne n - 1 i estimatet af populationsvariansen for den afhængige variabel, og df e er frihedsgraderne n - p - 1 for estimatet af den underliggende befolkningsfejlvariation.

Den justerede R 2 kan være negative, og dens værdi vil altid være mindre end eller lig med den for R 2 . Modsætning R 2 , de justerede R 2 stiger, når stigningen i R 2 (som følge af optagelse af en ny forklarende variabel) er mere end man ville forvente at se tilfældigt. Hvis et sæt forklarende variabler med en forudbestemt hierarki af betydning indføres i en regression en ad gangen, med den justeret R 2 beregnes hver gang, det niveau, hvor justerede R 2 når et maksimum og aftager bagefter, ville være regressionen med den ideelle kombination af at have den bedste pasform uden overskydende/unødvendige vilkår.

Justeret R 2 kan fortolkes som en mindre forspændt estimator af befolkningen R 2 , mens den observerede prøve R 2 er en positivt forspændt estimat af befolkningen værdi. Justeret R 2 er mere hensigtsmæssigt, når de evaluerer model fit (variansen i den afhængige variabel, som vedrører de uafhængige variable) og i at sammenligne alternative modeller i funktionen udvælgelse fase af model bygning.

Princippet bag den justerede R 2 -statistik kan ses ved at omskrive den almindelige R 2 som

hvor og er stikprøvevariationerne for henholdsvis de estimerede restværdier og den afhængige variabel, hvilket kan ses som forudindtaget skøn over populationsvariationerne af fejlene og for den afhængige variabel. Disse skøn erstattes af statistisk upartiske versioner: og .

Trods ved hjælp uvildige estimatorer for befolkningen varianser af fejlen og den afhængige variabel, justeret R 2 er ikke en estimator af befolkningen R 2 , hvilke resultater ved at bruge befolkningen varianser af de fejl og den afhængige variabel i stedet for at estimere dem. Ingram Olkin og John W. Pratt udledte den minimal-varians upartiske estimator for befolkningen R 2 , som er kendt som Olkin-Pratt estimator. Sammenligninger af forskellige tilgange til justering R 2 konkluderes, at i de fleste situationer enten en omtrentlig version af Olkin-Pratt estimator eller den nøjagtige Olkin-Pratt estimator bør foretrækkes frem (Ez) tilpasset R 2 .

Delbestemmelseskoefficient

Delbestemmelseskoefficienten kan defineres som andelen af variation, der ikke kan forklares i en reduceret model, men kan forklares med de forudsigere, der er angivet i en fuld (er) model. Denne koefficient bruges til at give indsigt i, om en eller flere yderligere forudsigere kan være nyttige i en mere fuldstændigt specificeret regressionsmodel.

Beregningen for den delvise R 2 er relativt ligetil efter estimering af to modeller og generering af ANOVA -tabeller for dem. Beregningen for den delvise R 2 er

som er analog med den sædvanlige bestemmelseskoefficient:

Generalisering og nedbrydning af R 2

Som forklaret ovenfor undersøger modelvalg heuristikker som det justerede kriterium og F-testen, om totalen stiger tilstrækkeligt til at afgøre, om en ny regressor skal føjes til modellen. Hvis der tilføjes en regressor til modellen, der er stærkt korreleret med andre regressorer, der allerede er inkluderet, så stiger totalet næppe, selvom den nye regressor er relevant. Som et resultat vil ovennævnte heuristik ignorere relevante regressorer, når krydskorrelationer er høje.

Alternativt kan man dekomponere en generaliseret version af for at kvantificere relevansen af at afvige fra en hypotese. Som Hoornweg (2018) viser, flere svind estimatorer - såsom Bayesian lineære regression , ridge regression , og (adaptive) lasso - gøre brug af denne nedbrydning af når de gradvist skrumpe parametre fra ubegrænset OLS løsninger i retning af hypotetiske værdier. Lad os først definere den lineære regressionsmodel som

Det antages, at matrixen er standardiseret med Z-score, og at søjlevektoren er centreret til at have et middelværdi på nul. Lad søjlevektoren referere til de hypotetiserede regressionsparametre og lad kolonnevektoren angive de estimerede parametre. Vi kan derefter definere

Et på 75% betyder, at nøjagtigheden i prøven forbedres med 75%, hvis de dataoptimerede løsninger bruges i stedet for de hypotetiserede værdier. I det særlige tilfælde, der er en vektor af nuller, får vi det traditionelle igen.

Den individuelle effekt på at afvige fra en hypotese kan beregnes med ('R-ydre'). Denne gange matrix er givet ved

hvor . De diagonale elementer i præcist tilføjer op til . Hvis regressorer er ukorrelerede og er en vektor af nuller, svarer det diagonale element simpelthen til værdien mellem og . Når regressorer og er korreleret, kan stige på bekostning af et fald i . Som følge heraf kan de diagonale elementer af være mindre end 0 og i mere undtagelsestilfælde større end 1. For at håndtere sådanne usikkerheder tager flere krympestimatører implicit et vægtet gennemsnit af de diagonale elementer for at kvantificere relevansen af at afvige fra en hypotetiseret værdi. Klik på lassoen for et eksempel.

R 2 i logistisk regression

I tilfælde af logistisk regression , der normalt passer med maksimal sandsynlighed , er der flere valg af pseudo-R 2 .

Den ene er den generaliserede R 2 oprindeligt foreslået af Cox & Snell, og uafhængigt af Magee:

hvor er sandsynligheden for modellen med kun skæringspunktet, er sandsynligheden for den estimerede model (dvs. modellen med et givet sæt parameterestimater) og n er stikprøvestørrelsen. Det omskrives let til:

hvor D er teststatistikken for sandsynlighedsforholdstesten .

Nagelkerke bemærkede, at det havde følgende egenskaber:

- Det er i overensstemmelse med den klassiske bestemmelseskoefficient, når begge kan beregnes;

- Dens værdi maksimeres ved den maksimale sandsynlighedsestimering af en model;

- Det er asymptotisk uafhængigt af prøvestørrelsen;

- Fortolkningen er andelen af variationen forklaret af modellen;

- Værdierne er mellem 0 og 1, hvor 0 angiver, at modellen ikke forklarer nogen variation, og 1 angiver, at den perfekt forklarer den observerede variation;

- Det har ikke nogen enhed.

Men i tilfælde af en logistisk model, hvor kan ikke være større end 1, R 2 er mellem 0 og : således, Nagelkerke foreslået muligheden for at definere en skaleret R 2 som R 2 / R 2 max .

Sammenligning med norm for restprodukter

Lejlighedsvis bruges normen for restprodukter til at indikere god pasform. Dette udtryk beregnes som kvadratroden af summen af kvadrater af rester :

Både R 2 og normen af restprodukter har deres relative fordele. For mindste kvadraters analyse R 2 varierer mellem 0 og 1, med større tal, der angiver bedre passer og 1 repræsenterer en perfekt pasform. Normen for rester varierer fra 0 til uendeligt med mindre tal, der angiver bedre pasninger og nul angiver en perfekt pasform. En fordel og ulempe ved R 2 er udtrykket virker til at normalisere værdien. Hvis y I værdier er alle multipliceret med en konstant, vil normen af restprodukter også ændre ved, at konstant, men R 2 vil forblive den samme. Som et grundlæggende eksempel passer de lineære mindste firkanter til datasættet:

R 2 = 0,998, og norm af restprodukter = 0,302. Hvis alle værdier af y multipliceres med 1000 (for eksempel i en SI-præfiks ændre), derefter R 2 forbliver den samme, men norm af restprodukter = 302.

En anden enkeltparameterindikator for tilpasning er RMSE for resterne eller standardafvigelse for resterne. Dette ville have en værdi på 0,135 for ovenstående eksempel, da tilpasningen var lineær med et uforceret skæringspunkt.

Historie

Oprettelsen af bestemmelseskoefficienten er blevet tilskrevet genetikeren Sewall Wright og blev første gang offentliggjort i 1921.

Se også

- Anscombes kvartet

- Variansfraktion uforklarlig

- Pasformens godhed

- Nash – Sutcliffe model effektivitetskoefficient ( hydrologiske anvendelser )

- Pearson produkt-moment korrelationskoefficient

- Proportionelt fald i tab

- Validering af regressionsmodel

- Rod betyder kvadratisk afvigelse

- Trinvis regression

- t -test af

Noter

Yderligere læsning

- Gujarati, Damodar N .; Porter, Dawn C. (2009). Grundlæggende økonometri (femte udgave). New York: McGraw-Hill/Irwin. s. 73–78. ISBN 978-0-07-337577-9.

- Hughes, Ann; Grawoig, Dennis (1971). Statistik: Et fundament for analyse . Læsning: Addison-Wesley. s. 344–348 . ISBN 0-201-03021-7.

- Kmenta, Jan (1986). Elements of Econometrics (anden udgave). New York: Macmillan. s. 240–243 . ISBN 978-0-02-365070-3.

- Lewis-Beck, Michael S .; Skalaban, Andrew (1990). "The R -Squared: Some Straight Talk". Politisk analyse . 2 : 153–171. doi : 10.1093/pan/2.1.153 . JSTOR 23317769 .

- Chicco, Davide; Warrens, Matthijs J .; Jurman, Giuseppe (2021). "Bestemmelseskoefficienten R-kvadrat er mere informativ end SMAPE, MAE, MAPE, MSE og RMSE i evaluering af regressionsanalyse" . PeerJ datalogi . 7 (e623): 1–24. doi : 10.7717/peerj-cs.623 .