Elevens t -test -Student's t-test

Den t -test er nogen statistisk hypotesetest , hvor teststørrelsen følger en Students t -fordeling under nulhypotesen .

En t -test er den mest almindeligt anvendte, når teststatistikken ville følge en normalfordeling, hvis værdien af et skaleringsudtryk i teststatistikken var kendt. Når skaleringsterminen er ukendt og erstattes af et estimat baseret på dataene , følger teststatistikken (under visse betingelser) en studerendes t -fordeling. Den t -test kan anvendes, for eksempel for at bestemme, om middelværdierne af to sæt data er signifikant forskellige fra hinanden.

Historie

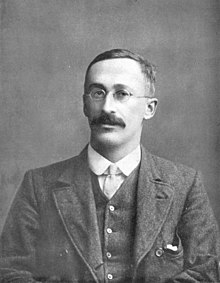

Udtrykket " t -statistisk" forkortes fra "hypoteseteststatistik". I statistikken blev t-distributionen først afledt som en posterior distribution i 1876 af Helmert og Lüroth . T-distributionen optrådte også i en mere generel form som Pearson Type IV- distribution i Karl Pearsons papir fra 1895. T-distributionen, også kendt som Student's T Distribution, får imidlertid sit navn fra William Sealy Gosset, der første gang udgav den på engelsk i 1908 i det videnskabelige tidsskrift Biometrika ved hjælp af sit pseudonym "Student", fordi hans arbejdsgiver foretrak at bruge psevnavne ved udgivelse videnskabelige artikler i stedet for deres rigtige navn, så han brugte navnet "Student" til at skjule sin identitet. Gosset arbejdede på Guinness Brewery i Dublin , Irland , og var interesseret i problemerne med små prøver - for eksempel de kemiske egenskaber ved byg med små prøvestørrelser. Derfor er en anden version af etymologien for udtrykket Student, at Guinness ikke ønskede, at deres konkurrenter skulle vide, at de brugte t -testen til at bestemme råmaterialets kvalitet (se Students t -distribution for en detaljeret historie om dette pseudonym, hvilket ikke må forveksles med det bogstavelige udtryk student ). Selvom det var William Gosset, efter hvem udtrykket "Student" er skrevet, var det faktisk gennem Ronald Fishers arbejde , at distributionen blev kendt som "Students distribution" og "Students t-test".

Gosset var blevet ansat på grund af Claude Guinness 'politik om at rekruttere de bedste kandidater fra Oxford og Cambridge til at anvende biokemi og statistik på Guinness industrielle processer. Gosset udtænkte t -testen som en økonomisk måde at overvåge kvaliteten af stout . Den t -test arbejde blev forelagt og godkendt i tidsskriftet Biometrika og offentliggjort i 1908.

Guinness havde en politik om at tillade teknisk personale orlov til studier (såkaldt "studieorlov"), som Gosset brugte i løbet af de første to perioder af studieåret 1906-1907 i professor Karl Pearsons biometriske laboratorium ved University College London . Gossets identitet var derefter kendt for andre statistikere og for chefredaktør Karl Pearson.

Anvendelser

Blandt de mest anvendte t -tests er:

- En én-prøve placering test af, hvorvidt middelværdien af en befolkning har en værdi angivet i en nul-hypotesen .

- En lokaltest med to stikprøver af nulhypotesen, således at middelværdien af to populationer er ens. Alle sådanne tests kaldes sædvanligvis Student's t -tests , men det navn bør strengt taget kun bruges, hvis variationerne i de to populationer også antages at være ens; formen for testen, der bruges, når denne antagelse falder, kaldes undertiden Welchs t -test . Disse tests omtales ofte som uparede eller uafhængige prøver t -test, da de typisk anvendes, når de statistiske enheder, der ligger til grund for de to prøver, der sammenlignes, ikke er overlappende.

Antagelser

De fleste teststatistikker har formen t = Z/s, hvor Z og s er funktionerne i dataene.

Z kan være følsom over for den alternative hypotese (dvs. dens størrelse har en tendens til at være større, når den alternative hypotese er sand), hvorimod s er en skaleringsparameter, der gør det muligt at bestemme fordelingen af t .

Som et eksempel i t -testen med én prøve

hvor X er prøvegennemsnittet fra en prøve X 1 , X 2 ,…, X n , af størrelse n , s er gennemsnitsfejl for middelværdien , er estimatet af standardafvigelsen for befolkningen, og μ er populationsgennemsnittet .

Forudsætningerne bag en t -test i den enkleste form ovenfor er, at:

- X følger en normalfordeling med middelværdi μ og variansσ 2/n

- s 2 ( n - 1)/ σ 2 følger en χ 2 -fordeling med n - 1 frihedsgrader . Denne antagelse opfyldes, når de observationer, der bruges til at estimere s 2, stammer fra en normalfordeling (og iid for hver gruppe).

- Z og s er uafhængige .

I t -testen, der sammenligner midlerne til to uafhængige prøver, skal følgende antagelser opfyldes:

- Midlerne til de to populationer, der skal sammenlignes, bør følge normalfordelinger . Under svage antagelser følger dette i store prøver fra den centrale grænsesætning , selv når observationsfordelingen i hver gruppe er ikke-normal.

- Hvis man anvender Students originale definition af t -testen, skal de to populationer, der sammenlignes, have den samme varians (testbar ved hjælp af F -test , Levene's test , Bartlett's test eller Brown – Forsythe -testen ; eller vurderes grafisk ved hjælp af et Q -Q -plot ). Hvis stikprøvestørrelserne i de to grupper, der sammenlignes, er ens, er Students originale t -test meget robust over for tilstedeværelsen af ulige variationer. Welchs t -test er ufølsom over for forskellene, uanset om prøvestørrelserne er ens.

- De data, der blev brugt til at udføre testen, skulle enten udtages uafhængigt af de to populationer, der blev sammenlignet, eller være fuldt parret. Dette kan generelt ikke testes ud fra dataene, men hvis data vides at være afhængige (f.eks. Parret med testdesign), skal der anvendes en afhængig test. For delvist parrede data kan de klassiske uafhængige t -tests give ugyldige resultater, da teststatistikken muligvis ikke følger en t -fordeling, mens den afhængige t -test er suboptimal, da den kasserer de uparrede data.

De fleste to -prøve -t -test er robuste over for alle, bortset fra store afvigelser fra antagelserne.

For nøjagtighed , den t -test og Z -test kræver normalitet af prøvegennemsnit, og t -test kræver desuden, at prøven varians følger en skaleret χ 2 fordeling , og at prøven middelværdi og variansen være statistisk uafhængige . Normalitet for de enkelte dataværdier er ikke påkrævet, hvis disse betingelser er opfyldt. Ved den centrale grænsesætning er sample-midler til moderat store prøver ofte godt tilnærmede ved en normalfordeling, selvom dataene ikke er normalt fordelt. For ikke-normale data kan fordelingen af prøvevariansen afvige væsentligt fra en χ 2- fordeling. Men hvis stikprøvestørrelsen er stor, indebærer Slutskys sætning , at fordelingen af prøvevariansen har ringe effekt på fordelingen af teststatistikken.

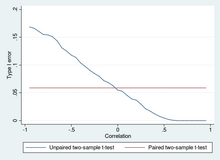

Uparret og parret to -prøve t -test

To -prøve -t -test for en forskel i middelværdi involverer uafhængige prøver (uparede prøver) eller parrede prøver. Parrede t -tests er en form for blokering og har større effekt (sandsynlighed for at undgå en type II -fejl, også kendt som en falsk negativ) end uparrede tests, når de parrede enheder er ens med hensyn til "støjfaktorer", der er uafhængige af medlemskab i de to grupper, der sammenlignes. I en anden kontekst kan parrede t -test bruges til at reducere virkningerne af forvirrende faktorer i et observationsstudie .

Uafhængige (uparrede) prøver

De uafhængige prøver t -test bruges, når der opnås to separate sæt uafhængige og identisk fordelte prøver, hvor en fra hver af de to populationer sammenlignes. Antag for eksempel, at vi evaluerer effekten af en medicinsk behandling, og vi tilmelder 100 forsøgspersoner til vores undersøgelse, og tilfældigt tildeler 50 forsøgspersoner til behandlingsgruppen og 50 forsøgspersoner til kontrolgruppen. I dette tilfælde har vi to uafhængige prøver og ville bruge den uparrede form for t -testen.

Parrede prøver

Parrede prøver t -test består typisk af en prøve af matchede par af lignende enheder eller en gruppe af enheder, der er blevet testet to gange (en "gentagne målinger" t -test).

Et typisk eksempel på de gentagne målinger t- test ville være, hvor forsøgspersoner blev testet før en behandling, f.eks. For forhøjet blodtryk, og de samme forsøgspersoner blev testet igen efter behandling med en blodtrykssænkende medicin. Ved at sammenligne den samme patients tal før og efter behandlingen, bruger vi effektivt hver patient som deres egen kontrol. På den måde kan den korrekte afvisning af nulhypotesen (her: af ingen forskel foretaget af behandlingen) blive meget mere sandsynlig, med statistisk magt øget simpelthen fordi den tilfældige interpatientvariation nu er elimineret. Imidlertid har en stigning i statistisk magt en pris: flere test er påkrævet, hvor hvert emne skal testes to gange. Fordi halvdelen af prøven nu afhænger af den anden halvdel, har den parrede version af Students t -test kunn/2- 1 frihedsgrader (hvor n er det samlede antal observationer). Par bliver individuelle testenheder, og prøven skal fordobles for at opnå samme antal frihedsgrader. Normalt er der n - 1 frihedsgrader (hvor n er det samlede antal observationer).

En parret prøve t -test baseret på en "matchet par -prøve" stammer fra en uparret prøve, der efterfølgende bruges til at danne en parret prøve, ved hjælp af yderligere variabler, der blev målt sammen med variablen af interesse. Matchningen udføres ved at identificere par af værdier, der består af en observation fra hver af de to prøver, hvor parret er ens med hensyn til andre målte variabler. Denne tilgang bruges undertiden i observationsstudier til at reducere eller eliminere virkningerne af forvirrende faktorer.

Parrede prøver t -tests omtales ofte som "afhængige prøver t -test".

Beregninger

Eksplicitte udtryk, der kan bruges til at udføre forskellige t -tests, er angivet nedenfor. I hvert tilfælde gives formlen for en teststatistik, der enten nøjagtigt følger eller nærmer sig en t -fordeling under nulhypotesen. Desuden gives de passende frihedsgrader i hvert tilfælde. Hver af disse statistikker kan bruges til at udføre enten en ensidig eller tohalet test .

Når t -værdien og frihedsgraderne er bestemt, kan en p -værdi findes ved hjælp af en værditabel fra Students t -distribution . Hvis den beregnede p -værdi er under den tærskel, der er valgt for statistisk signifikans (normalt niveauet 0,10, 0,05 eller 0,01), afvises nulhypotesen til fordel for den alternative hypotese.

En prøve t -test

Ved test af nulhypotesen om, at populationsmiddelværdien er lig med en bestemt værdi μ 0 , bruger man statistikken

hvor er prøveværdien, s er prøvens standardafvigelse og n er stikprøvestørrelsen. De frihedsgrader, der bruges i denne test, er n - 1 . Selvom forældrepopulationen ikke behøver at være normalfordelt, antages fordelingen af populationen af prøveorganer at være normal.

Ved den centrale grænsesætning , hvis observationerne er uafhængige, og det andet øjeblik eksisterer, vil det være omtrent normalt N (0; 1).

Hældning af en regressionslinje

Antag, at en passer til modellen

hvor x er kendt, α og β er ukendte, ε er en normalt fordelt tilfældig variabel med middelværdi 0 og ukendt varians σ 2 , og Y er resultatet af interesse. Vi vil teste nulhypotesen om, at hældningen β er lig med en bestemt værdi β 0 (ofte antaget til at være 0, i hvilket tilfælde nulhypotesen er, at x og y er ukorrelerede).

Lade

Derefter

har en t -fordeling med n -2 frihedsgrader, hvis nulhypotesen er sand. Den standardfejl på hældningskoefficienten :

kan skrives i form af resterne. Lade

Derefter t score er givet ved:

En anden måde at bestemme t -score på er:

hvor r er Pearson -korrelationskoefficienten .

Den t score, opfange kan bestemmes ud fra den t score, hældning :

hvor s x 2 er prøvevariansen.

Uafhængig to -prøve t -test

Lige prøvestørrelser og varians

I betragtning af to grupper (1, 2) er denne test kun gældende, når:

- de to stikprøvestørrelser (dvs. antallet n af deltagere i hver gruppe) er ens;

- det kan antages, at de to fordelinger har samme varians;

Overtrædelser af disse antagelser diskuteres nedenfor.

Den t statistik til test om de midler er forskellige, kan beregnes som følger:

hvor

Her er p den samlede standardafvigelse for n = n 1 = n 2 og s 2

X 1og s 2

X 2er de upartiske estimatorer for variationerne i de to prøver. Nævneren af t er standardfejlen ved forskellen mellem to midler.

Ved signifikansprøvning er frihedsgraderne for denne test 2 n - 2, hvor n er antallet af deltagere i hver gruppe.

Lige eller ulige prøvestørrelser, lignende afvigelser (1/2 < s X 1/s X 2 <2)

Denne test bruges kun, når det kan antages, at de to fordelinger har samme varians. (Når denne antagelse er overtrådt, se nedenfor.) De tidligere formler er et specielt tilfælde af formlerne nedenfor, man gendanner dem, når begge prøver er lige store: n = n 1 = n 2 .

Den t statistik til test om de midler er forskellige, kan beregnes som følger:

hvor

er en estimator for den samlede standardafvigelse for de to prøver: den defineres på denne måde, så dens firkant er en upartisk estimator af den fælles varians, uanset om populationsmidlerne er de samme. I disse formler er n i - 1 antallet af frihedsgrader for hver gruppe, og den samlede stikprøvestørrelse minus to (det vil sige n 1 + n 2 - 2 ) er det samlede antal frihedsgrader, der bruges i betydningstest.

Lige eller ulige prøvestørrelser, ulige variationer ( s X 1 > 2 s X 2 eller s X 2 > 2 s X 1 )

Denne test, også kendt som Welchs t -test, bruges kun, når de to populationsvariationer ikke antages at være ens (de to prøve størrelser kan være ens eller ikke) og skal derfor estimeres separat. Den t statistik til test, om populationsmiddelværdier er forskellige beregnes som:

hvor

Her er i i 2 den upartiske estimator af variansen for hver af de to prøver med n i = antal deltagere i gruppe i ( i = 1 eller 2). I dette tilfælde er det ikke en samlet varians. Til brug ved signifikansafprøvning tilnærmes fordelingen af teststatistikken som en almindelig studerendes t -fordeling med frihedsgrader beregnet ved hjælp af

Dette er kendt som Welch -Satterthwaite -ligningen . Den sande fordeling af teststatistikken afhænger faktisk (lidt) af de to ukendte befolkningsvariationer (se Behrens – Fisher -problem ).

Afhængig t -test for parrede prøver

Denne test bruges, når prøverne er afhængige; det vil sige, når der kun er én prøve, der er blevet testet to gange (gentagne målinger), eller når der er to prøver, der er blevet matchet eller "parret". Dette er et eksempel på en parret differenstest . Den t statistik beregnes som

hvor og er gennemsnittet og standardafvigelsen af forskellene mellem alle par. Parrene er f.eks. Enten en persons præ-test og post-test scoringer eller mellem-par personer matchet i meningsfulde grupper (f.eks. Hentet fra samme familie eller aldersgruppe: se tabel). Konstanten μ 0 er nul, hvis vi vil teste, om gennemsnittet af forskellen er signifikant forskelligt. Den anvendte frihedsgrad er n - 1 , hvor n repræsenterer antallet af par.

Eksempel på gentagne foranstaltninger Nummer Navn Test 1 Test 2 1 Mike 35% 67% 2 Melanie 50% 46% 3 Melissa 90% 86% 4 Mitchell 78% 91%

Eksempel på matchede par Par Navn Alder Prøve 1 John 35 250 1 Jane 36 340 2 Jimmy 22 460 2 Jessy 21 200

Udarbejdede eksempler

Lad A 1 betegne et sæt opnået ved at tegne en stikprøve på seks målinger:

og lad A 2 betegne et andet sæt opnået på samme måde:

Det kan for eksempel være vægte af skruer, der blev valgt ud af en spand.

Vi vil udføre test af nulhypotesen om, at middelværdien af de populationer, hvorfra de to prøver blev taget, er ens.

Forskellen mellem de to prøveorganer, hver betegnet med X i , som optræder i tælleren for alle de to-prøve-testmetoder, der er diskuteret ovenfor, er

Prøven standardafvigelser for de to prøver er henholdsvis cirka 0,05 og 0,11. For så små prøver ville en test af lighed mellem de to befolkningsvariationer ikke være særlig kraftig. Da prøvestørrelserne er ens, vil de to former for t -prøve -t -testen udføre på samme måde i dette eksempel.

Ulige forskelle

Hvis metoden til ulige afvigelser (diskuteret ovenfor) følges, er resultaterne

og frihedsgrader

Teststatistikken er cirka 1,959, hvilket giver en to -halet test p -værdi på 0,09077.

Lige afvigelser

Hvis metoden til lige afvigelser (diskuteret ovenfor) følges, er resultaterne

og frihedsgrader

Teststatistikken er omtrent lig med 1,959, hvilket giver en to -halet p -værdi på 0,07857.

Relaterede statistiske tests

Alternativer til t -testen for lokaliseringsproblemer

Den t -test giver en nøjagtig test for ligestilling af midlerne til to IId normale populationer med ukendt, men lig, varianser. ( Welchs t -test er en næsten nøjagtig test for det tilfælde, hvor dataene er normale, men afvigelserne kan variere.) For moderat store prøver og en enhalet test er t -testen relativt robust til moderate krænkelser af normalitetsantagelsen. I store nok prøver nærmer t -testen sig asymptotisk z -testen og bliver robust selv over for store afvigelser fra normalitet.

Hvis dataene i det væsentlige er ikke -normale, og stikprøvestørrelsen er lille, kan t -testen give vildledende resultater. Se placeringstest for blandinger i Gaussisk skala for nogle teorier relateret til en bestemt familie af ikke-normale fordelinger.

Når normalitetsantagelsen ikke holder, kan et ikke -parametrisk alternativ til t -testen have bedre statistisk magt . Men når data er ikke-normale med forskellige afvigelser mellem grupper, kan en t-test have bedre type-1 fejlkontrol end nogle ikke-parametriske alternativer. Desuden tester ikke-parametriske metoder, såsom Mann-Whitney U-testen, der er diskuteret nedenfor, typisk ikke for forskelle i midler, så de bør bruges omhyggeligt, hvis en forskel mellem midler er af primær videnskabelig interesse. For eksempel vil Mann-Whitney U-test beholde type 1-fejlen på det ønskede niveau alfa, hvis begge grupper har den samme fordeling. Det vil også have magt til at opdage et alternativ, ved hvilket gruppe B har den samme fordeling som A, men efter et eller andet skift med en konstant (i så fald ville der faktisk være en forskel i de to gruppers midler). Imidlertid kan der være tilfælde, hvor gruppe A og B vil have forskellige fordelinger, men med de samme midler (f.eks. To fordelinger, den ene med positiv skævhed og den anden med en negativ, men skiftede for at have de samme midler). I sådanne tilfælde kunne MW have mere end alfa -niveau magt til at afvise Nul -hypotesen, men at tilskrive fortolkningen af forskelle i midler til et sådant resultat ville være forkert.

I nærvær af en outlier er t-testen ikke robust. For eksempel for to uafhængige prøver, når datadistributionerne er asymmetriske (det vil sige, at fordelingerne er skæve ) eller fordelingerne har store haler, kan Wilcoxon-rangsumtesten (også kendt som Mann – Whitney U- testen ) have tre til fire gange højere effekt end t -testen. Den ikke -parametriske modstykke til de parrede prøver t -test er Wilcoxons signerede rangtest for parrede prøver. For en diskussion om valg mellem t -test og ikke -parametriske alternativer, se Lumley et al. (2002).

Envejs variansanalyse (ANOVA) generaliserer to-prøve- t- testen, når dataene tilhører mere end to grupper.

Et design, der omfatter både parrede observationer og uafhængige observationer

Når både parrede observationer og uafhængige observationer er til stede i de to prøvedesign, forudsat at data mangler helt tilfældigt (MCAR), kan de parrede observationer eller uafhængige observationer kasseres for at fortsætte med standardtestene ovenfor. Alternativt ved at bruge alle de tilgængelige data under forudsætning af normalitet og MCAR kunne den generaliserede delvist overlappende prøve t-test bruges.

Multivariat test

En generalisering af Students t -statistik, kaldet Hotellings t -squared -statistik , giver mulighed for at teste hypoteser på flere (ofte korrelerede) målinger inden for samme prøve. For eksempel kan en forsker indsende et antal emner til en personlighedstest bestående af flere personlighedsskalaer (f.eks. Minnesota Multifasic Personality Inventory ). Fordi foranstaltninger af denne type normalt er positivt korrelerede, er det ikke tilrådeligt at foretage separate univariate t -test for at teste hypoteser, da disse ville negligere kovariansen mellem foranstaltninger og øge chancen for falsk at afvise mindst en hypotese ( type I -fejl ). I dette tilfælde foretrækkes en enkelt multivariat test til hypotesetest. Fishers metode til at kombinere flere tests med alfa reduceret til positiv korrelation mellem test er en. En anden er Hotellings T 2 -statistik, der følger en T 2 -fordeling. I praksis bruges fordelingen imidlertid sjældent, da tabulerede værdier for T 2 er svære at finde. Normalt konverteres T 2 i stedet til en F -statistik.

For en multivariat test med én prøve er hypotesen, at middelvektoren ( μ ) er lig med en given vektor ( μ 0 ). Teststatistikken er Hotellings t 2 :

hvor n er prøvestørrelsen, x er vektoren for søjlemidler og S er en m × m prøvekovariansmatrix .

For en multivariat test med to prøver er hypotesen, at middelvektorerne ( μ 1 , μ 2 ) for to prøver er ens. Teststatistikken er Hotellings to-prøve t 2 :

Softwareimplementeringer

Mange regnearksprogrammer og statistikpakker, såsom QtiPlot , LibreOffice Calc , Microsoft Excel , SAS , SPSS , Stata , DAP , gretl , R , Python , PSPP , MATLAB og Minitab , inkluderer implementeringer af Students t -test.

| Sprog/program | Fungere | Noter |

|---|---|---|

| Microsoft Excel før 2010 | TTEST(array1, array2, tails, type) |

Se [1] |

| Microsoft Excel 2010 og senere | T.TEST(array1, array2, tails, type) |

Se [2] |

| LibreOffice Calc | TTEST(Data1; Data2; Mode; Type) |

Se [3] |

| Google Sheets | TTEST(range1, range2, tails, type) |

Se [4] |

| Python | scipy.stats.ttest_ind(a, b, equal_var=True) |

Se [5] |

| MATLAB | ttest(data1, data2) |

Se [6] |

| Mathematica | TTest[{data1,data2}] |

Se [7] |

| R | t.test(data1, data2, var.equal=TRUE) |

Se [8] |

| SAS | PROC TTEST |

Se [9] |

| Java | tTest(sample1, sample2) |

Se [10] |

| Julia | EqualVarianceTTest(sample1, sample2) |

Se [11] |

| Stata | ttest data1 == data2 |

Se [12] |

Se også

Referencer

Citater

Kilder

- O'Mahony, Michael (1986). Sensorisk vurdering af mad: Statistiske metoder og procedurer . CRC Tryk . s. 487. ISBN 0-82477337-3.

- Press, William H .; Teukolsky, Saul A .; Vetterling, William T .; Flannery, Brian P. (1992). Numeriske opskrifter i C: The Art of Scientific Computing . Cambridge University Press . s. 616 . ISBN 0-521-43108-5.

Yderligere læsning

- Boneau, C. Alan (1960). "Virkningerne af krænkelser af antagelser, der ligger til grund for t -testen". Psykologisk bulletin . 57 (1): 49–64. doi : 10.1037/h0041412 . PMID 13802482 .

- Edgell, Stephen E .; Middag, Sheila M. (1984). "Virkning af krænkelse af normalitet på t -testen af korrelationskoefficienten". Psykologisk bulletin . 95 (3): 576–583. doi : 10.1037/0033-2909.95.3.576 .

eksterne links

- "Studenttest" , Encyclopedia of Mathematics , EMS Press , 2001 [1994]

- Trochim, William MK " The T-Test ", Research Methods Knowledge Base , conjoint.ly

- Econometrics -foredrag (emne: hypotesetest) på YouTube af Mark Thoma