Søgemaskine optimering - Search engine optimization

| Del af en serie om |

| Internet marketing |

|---|

| Søgemaskine marketing |

| Displayannoncering |

| Affiliate marketing |

| Mobil annoncering |

Søgemaskineoptimering ( SEO ) er processen med at forbedre kvaliteten og mængden af webstedstrafik til et websted eller en webside fra søgemaskiner . SEO er målrettet mod ulønnet trafik (kendt som "naturlige" eller " organiske " resultater) frem for direkte trafik eller betalt trafik . Ubetalt trafik kan stamme fra forskellige slags søgninger, herunder billedsøgning , videosøgning , akademisk søgning , nyhedssøgning og branchespecifikke lodrette søgemaskiner.

Som en internetmarkedsføringsstrategi overvejer SEO, hvordan søgemaskiner fungerer, de computerprogrammerede algoritmer, der dikterer søgemaskiners adfærd, hvad folk søger efter, de faktiske søgeudtryk eller søgeord, der er skrevet i søgemaskiner, og hvilke søgemaskiner der foretrækkes af deres målgruppe . SEO udføres, fordi et websted vil modtage flere besøgende fra en søgemaskine, når websteder rangerer højere på søgemaskinens resultatside (SERP). Disse besøgende kan derefter potentielt konverteres til kunder.

Historie

Webmastere og indholdsudbydere begyndte at optimere websteder til søgemaskiner i midten af 1990'erne, da de første søgemaskiner katalogiserede det tidlige web . I første omgang behøvede alle webmastere kun at indsende adressen på en side eller URL til de forskellige motorer, som ville sende en webcrawler til at gennemgå den side, udtrække links til andre sider fra den og returnere oplysninger, der findes på siden, der skulle indekseres . Processen indebærer, at en søgemaskinespider downloader en side og gemmer den på søgemaskinens egen server. Et andet program, kendt som en indekser , udtrækker oplysninger om siden, f.eks. De ord, den indeholder, hvor de er placeret, og enhver vægt for bestemte ord, samt alle links, siden indeholder. Alle disse oplysninger placeres derefter i en planlægger til gennemgang på et senere tidspunkt.

Websitetsejere anerkendte værdien af en høj placering og synlighed i søgemaskineresultater, hvilket skabte en mulighed for både hvid hat og sort hat SEO -praktikere. Ifølge brancheanalytiker Danny Sullivan kom udtrykket "søgemaskineoptimering" sandsynligvis i brug i 1997. Sullivan krediterer Bruce Clay som en af de første mennesker til at popularisere udtrykket.

Tidlige versioner af søgning algoritmer påberåbt webmaster-forudsat information såsom søgeordet meta-tag eller index-filer i motorer som ALIWEB . Metatags giver en vejledning til hver sides indhold. Brug af metadata til at indeksere sider viste sig imidlertid at være mindre end pålideligt, fordi webmasters valg af søgeord i metataggen potentielt kunne være en unøjagtig gengivelse af webstedets faktiske indhold. Fejlbehæftede data i metatags, f.eks. Dem, der ikke var nøjagtige, fuldstændige eller fejlagtige attributter, skabte potentiale for, at sider blev fejlkarakteriseret i irrelevante søgninger. Webindholdsudbydere manipulerede også nogle attributter inden for HTML -kilden til en side i et forsøg på at placere sig godt i søgemaskiner. I 1997 erkendte søgemaskinedesignere, at webmastere forsøgte at rangere godt i deres søgemaskine, og at nogle webmastere endda manipulerede deres placeringer i søgeresultater ved at proppe sider med overdrevne eller irrelevante søgeord. Tidlige søgemaskiner, såsom Altavista og Infoseek , justerede deres algoritmer for at forhindre webmastere i at manipulere placeringer.

Ved stærkt at stole på faktorer som søgeordstæthed , som udelukkende var inden for en webmasters kontrol, led tidlige søgemaskiner under misbrug og rangering af manipulation. For at give deres brugere bedre resultater måtte søgemaskiner tilpasse sig for at sikre, at deres resultatsider viste de mest relevante søgeresultater frem for ikke -relaterede sider fyldt med talrige søgeord fra skrupelløse webmastere. Dette betød at flytte væk fra stor afhængighed af termtæthed til en mere holistisk proces til scoring af semantiske signaler. Da en søgemaskines succes og popularitet bestemmes af dens evne til at producere de mest relevante resultater til enhver given søgning, kan dårlig kvalitet eller irrelevante søgeresultater få brugerne til at finde andre søgekilder. Søgemaskiner reagerede ved at udvikle mere komplekse rangeringsalgoritmer under hensyntagen til yderligere faktorer, der var vanskeligere for webmastere at manipulere.

Virksomheder, der anvender alt for aggressive teknikker, kan få deres klientwebsteder udelukket fra søgeresultaterne. I 2005 rapporterede Wall Street Journal om et firma, Traffic Power , der angiveligt brugte højrisikoteknikker og ikke formåede at oplyse disse risici til sine kunder. Magasinet Wired rapporterede, at det samme selskab sagsøgte blogger og SEO Aaron Wall for at have skrevet om forbuddet. Googles Matt Cutts bekræftede senere, at Google faktisk forbød Traffic Power og nogle af dets klienter.

Nogle søgemaskiner har også nået SEO -branchen og er hyppige sponsorer og gæster ved SEO -konferencer, webchats og seminarer. Store søgemaskiner giver oplysninger og retningslinjer for at hjælpe med webstedsoptimering. Google har et sitemaps -program, der hjælper webmastere med at finde ud af, om Google har problemer med at indeksere deres websted og også giver data om Google -trafik til webstedet. Bing Webmasterværktøjer giver webmastere mulighed for at indsende et sitemap og webfeeds, giver brugerne mulighed for at bestemme "gennemgangshastighed" og spore indeksstatus for websider.

I 2015 blev det rapporteret, at Google udviklede og promoverede mobilsøgning som en nøglefunktion inden for fremtidige produkter. Som svar begyndte mange mærker at tage en anden tilgang til deres internetmarkedsføringsstrategier.

Forholdet til Google

I 1998 udviklede to kandidatstuderende ved Stanford University , Larry Page og Sergey Brin , "Backrub", en søgemaskine, der baserede sig på en matematisk algoritme til at bedømme websiders fremtrædelse. Antallet beregnet af algoritmen, PageRank , er en funktion af mængden og styrken af indgående links . PageRank vurderer sandsynligheden for, at en given side vil blive nået af en webbruger, der tilfældigt surfer på nettet og følger links fra en side til en anden. Det betyder faktisk, at nogle links er stærkere end andre, da en højere PageRank -side mere sandsynligt vil blive nået af den tilfældige websurfer.

Page og Brin grundlagde Google i 1998. Google tiltrak en loyal tilhænger blandt det stigende antal internetbrugere , der kunne lide dets enkle design. Off-side faktorer (såsom PageRank og hyperlink analyse) blev overvejet såvel som on-side faktorer (såsom søgeordsfrekvens, metatags , overskrifter, links og webstedsstruktur) for at gøre det muligt for Google at undgå den form for manipulation, der ses i søgemaskiner der kun betragtede faktorer på siden for deres placeringer. Selvom PageRank var sværere at spille , havde webmastere allerede udviklet værktøjer til opbygning af links og ordninger for at påvirke Inktomi -søgemaskinen , og disse metoder viste sig tilsvarende at kunne bruges til gaming PageRank. Mange websteder fokuserede på at udveksle, købe og sælge links, ofte i massiv skala. Nogle af disse ordninger eller linkfarme involverede oprettelse af tusindvis af websteder med det ene formål at linke spam .

I 2004 havde søgemaskiner indarbejdet en lang række ikke -oplyste faktorer i deres rangeringsalgoritmer for at reducere virkningen af linkmanipulation. I juni 2007 udtalte The New York Times ' Saul Hansell, at Google rangerer websteder, der bruger mere end 200 forskellige signaler. De førende søgemaskiner, Google, Bing og Yahoo , afslører ikke de algoritmer, de bruger til at rangere sider. Nogle SEO -praktikere har undersøgt forskellige tilgange til søgemaskineoptimering og har delt deres personlige meninger. Patenter relateret til søgemaskiner kan give oplysninger for bedre at forstå søgemaskiner. I 2005 begyndte Google at tilpasse søgeresultater for hver bruger. Afhængigt af deres historik med tidligere søgninger udarbejdede Google resultater for loggede brugere.

I 2007 annoncerede Google en kampagne mod betalte links, der overfører PageRank. Den 15. juni 2009 afslørede Google, at de havde truffet foranstaltninger til at afbøde virkningerne af PageRank -skulptur ved hjælp af attributten nofollow på links. Matt Cutts , en kendt softwareingeniør hos Google, meddelte, at Google Bot ikke længere ville behandle nofollow-links på samme måde for at forhindre SEO-tjenesteudbydere i at bruge nofollow til PageRank-skulpturering. Som et resultat af denne ændring førte brugen af nofollow til fordampning af PageRank. For at undgå ovenstående udviklede SEO -ingeniører alternative teknikker, der erstatter ikke -fulgte tags med skjult JavaScript og dermed tillader PageRank -skulptur. Derudover er der foreslået flere løsninger, der inkluderer brug af iframes , Flash og JavaScript.

I december 2009 meddelte Google, at det ville bruge alle sine brugeres søgehistorik til at udfylde søgeresultater. Den 8. juni 2010 blev et nyt webindekseringssystem kaldet Google Caffeine annonceret. Designet til at give brugerne mulighed for at finde nyhedsresultater, forumindlæg og andet indhold meget hurtigere efter publicering end tidligere, var Google Caffeine en ændring af den måde, hvorpå Google opdaterede sit indeks for at få tingene til at vise sig hurtigere på Google end før. Ifølge Carrie Grimes, softwareingeniøren, der annoncerede koffein til Google, "Koffein giver 50 procent friskere resultater for websøgninger end vores sidste indeks ..." Google Instant , real-time-søgning, blev introduceret i slutningen af 2010 i et forsøg på at gøre søgeresultater mere rettidige og relevante. Historisk set har webstedsadministratorer brugt måneder eller endda år på at optimere et websted for at øge søgerangeringer. Med stigningen i popularitet på sociale medier og blogs foretog de førende motorer ændringer i deres algoritmer, så frisk indhold hurtigt kunne rangeres inden for søgeresultaterne.

I februar 2011 annoncerede Google Panda -opdateringen, som straffer websteder, der indeholder indhold, der er duplikeret fra andre websteder og kilder. Historisk set har websteder kopieret indhold fra hinanden og nydt godt af søgemaskinernes placeringer ved at deltage i denne praksis. Imidlertid implementerede Google et nyt system, der straffer websteder, hvis indhold ikke er unikt. Google Penguin fra 2012 forsøgte at straffe websteder, der brugte manipulerende teknikker til at forbedre deres placeringer på søgemaskinen. Selvom Google Penguin er blevet præsenteret som en algoritme, der sigter mod at bekæmpe web -spam, fokuserer den virkelig på spam -links ved at måle kvaliteten af de websteder, som linkene kommer fra. Opdateringen til Google Hummingbird fra 2013 indeholdt en algoritmeændring designet til at forbedre Googles behandling af naturligt sprog og semantisk forståelse af websider. Hummingbirds sprogbehandlingssystem falder ind under det nyligt anerkendte udtryk " samtalesøgning ", hvor systemet er mere opmærksom på hvert ord i forespørgslen for bedre at kunne matche siderne med forespørgselens betydning frem for et par ord. Med hensyn til de ændringer, der er foretaget til søgemaskineoptimering, for indholdsudgivere og forfattere, er Hummingbird beregnet til at løse problemer ved at slippe af med irrelevant indhold og spam, så Google kan producere indhold af høj kvalitet og stole på, at de er 'betroede' forfattere .

I oktober 2019 meddelte Google, at de ville begynde at anvende BERT -modeller til engelsksprogede søgeforespørgsler i USA. Bidirectional Encoder Representations from Transformers (BERT) var endnu et forsøg fra Google på at forbedre deres naturlige sprogbehandling, men denne gang for bedre at forstå deres brugeres søgeforespørgsler. Med hensyn til søgemaskineoptimering havde BERT til hensigt lettere at forbinde brugere med relevant indhold og øge kvaliteten af trafikken til websteder, der er placeret på søgemaskinens resultatside.

Metoder

Bliver indekseret

De førende søgemaskiner, såsom Google, Bing og Yahoo !, bruger crawlers til at finde sider til deres algoritmiske søgeresultater. Sider, der er linket fra andre søgemaskineindekserede sider, behøver ikke at indsendes, fordi de findes automatisk. Den Yahoo! Directory og DMOZ , to store biblioteker, der lukkede i henholdsvis 2014 og 2017, både krævede manuel indsendelse og menneskelig redaktionel gennemgang. Google tilbyder Google Search Console , hvortil der kan oprettes og indsendes et XML Sitemap -feed for at sikre, at alle sider findes, især sider, der ikke kan opdages ved automatisk at følge links ud over deres webadressekonsol. Yahoo! tidligere drev en betalt indsendelsestjeneste, der garanterede gennemgang for en pris pr. klik ; denne praksis blev imidlertid afbrudt i 2009.

Søgemaskinecrawlere kan se på en række forskellige faktorer, når de gennemgår et websted. Ikke hver side er indekseret af søgemaskinerne. Afstanden mellem sider fra rodmappen på et websted kan også være en faktor i, om sider bliver gennemgået eller ej.

I dag søger de fleste på Google ved hjælp af en mobilenhed. I november 2016 annoncerede Google en større ændring af måden at crawle websteder på og begyndte at gøre deres indeks mobil-først, hvilket betyder, at mobilversionen af et givet websted bliver udgangspunktet for, hvad Google inkluderer i deres indeks. I maj 2019 opdaterede Google gengivelsesmotoren for deres crawler til at være den nyeste version af Chromium (74 på tidspunktet for meddelelsen). Google angav, at de regelmæssigt ville opdatere Chromium -gengivelsesmotoren til den nyeste version. I december 2019 begyndte Google at opdatere bruger-agent-strengen i deres crawler for at afspejle den nyeste Chrome-version, der blev brugt af deres gengivelsestjeneste. Forsinkelsen var at give webmastere tid til at opdatere deres kode, der reagerede på bestemte bot User-Agent-strenge. Google kørte evalueringer og følte sig overbevist om, at virkningen ville være mindre.

Forhindrer kravl

For at undgå uønsket indhold i søgeindekserne kan webmastere instruere edderkopper om ikke at gennemgå bestemte filer eller mapper gennem standard robots.txt -filen i domænet. Derudover kan en side eksplicit udelukkes fra en søgemaskines database ved hjælp af et metatag specifikt for robotter (normalt <meta name = "robots" content = "noindex">). Når en søgemaskine besøger et websted, er robots.txt, der findes i rodmappen, den første fil, der gennemgås. Robotten.txt -filen analyseres derefter og instruerer robotten i, hvilke sider der ikke skal gennemsøges. Da en søgemaskine -crawler kan gemme en cachelagret kopi af denne fil, kan den til tider gennemgå sider, som en webmaster ikke ønsker crawlet. Sider, der typisk forhindres i at blive crawlet, omfatter loginspecifikke sider såsom indkøbsvogne og brugerspecifikt indhold, f.eks. Søgeresultater fra interne søgninger. I marts 2007 advarede Google webmastere om, at de skulle forhindre indeksering af interne søgeresultater, fordi disse sider betragtes som søppelpost. I 2020 nedsatte Google standarden (og åbnede deres kode) og behandler den nu som et tip ikke et direktiv. For på en tilstrækkelig måde at sikre, at sider ikke indekseres, bør et metatag på sideniveau være inkluderet.

Stigende fremtrædelse

En række forskellige metoder kan øge fremkomsten af en webside i søgeresultaterne. Krydsforbindelse mellem sider på det samme websted for at give flere links til vigtige sider kan forbedre dets synlighed. Sidedesign får brugerne til at stole på et websted og vil blive, når de finder det. Når folk hopper fra et websted, tæller det imod webstedet og påvirker deres troværdighed. At skrive indhold, der indeholder ofte søgt søgeordssætning, så det er relevant for en lang række søgeforespørgsler, har en tendens til at øge trafikken. Opdatering af indhold, så søgemaskiner ofte kan kravle tilbage, kan give et websted ekstra vægt. Tilføjelse af relevante søgeord til en websides metadata, herunder titeltag og metabeskrivelse , har en tendens til at forbedre relevansen af et websteds søgelister og dermed øge trafikken. URL -kanonisering af websider, der er tilgængelige via flere webadresser, ved hjælp af det kanoniske linkelement eller via 301 omdirigeringer kan hjælpe med at sikre, at links til forskellige versioner af URL'en alle tæller med på sidens link -popularitetsresultat. Disse er kendt som indgående links, som peger på webadressen og kan tælle med i sidelinkets popularitetsresultat, hvilket påvirker et websteds troværdighed.

I den seneste tid prioriterer Google også nedenstående elementer til SERP (Search Engine Ranking Position) mere.

- HTTPS -version (Secure Site)

- Sidehastighed

- Strukturerede data

- Mobil kompatibilitet

- AMP (Accelerated Mobile Pages)

- BERT

Hvid hat versus sort hatteknik

SEO -teknikker kan inddeles i to brede kategorier: teknikker, som søgemaskinefirmaer anbefaler som en del af et godt design ("hvid hat"), og de teknikker, som søgemaskiner ikke godkender ("sort hat"). Søgemaskinerne forsøger at minimere effekten af sidstnævnte, herunder spamdexing . Industrikommentatorer har klassificeret disse metoder og de praktiserende læger, der anvender dem, som enten hvid hat SEO eller sort hat SEO. Hvide hatte har en tendens til at producere resultater, der holder længe, hvorimod sorte hatte forudser, at deres websteder i sidste ende kan blive forbudt enten midlertidigt eller permanent, når søgemaskinerne finder ud af, hvad de laver.

En SEO -teknik betragtes som hvid hat, hvis den er i overensstemmelse med søgemaskinernes retningslinjer og ikke indebærer bedrag. Da søgemaskinens retningslinjer ikke er skrevet som en række regler eller bud, er dette en vigtig forskel at bemærke. White hat SEO handler ikke kun om at følge retningslinjer, men handler om at sikre, at det indhold, en søgemaskine indekserer og efterfølgende rangerer, er det samme indhold, som en bruger vil se. White hat -råd er generelt opsummeret som at skabe indhold til brugere, ikke til søgemaskiner, og derefter gøre det indhold let tilgængeligt for online "edderkop" -algoritmerne, snarere end at forsøge at narre algoritmen fra dets tilsigtede formål. White hat SEO ligner på mange måder webudvikling, der fremmer tilgængelighed, selvom de to ikke er identiske.

Black hat SEO forsøger at forbedre placeringer på måder, som søgemaskinerne ikke godkender eller involverer bedrag. Én sort hatteknik bruger skjult tekst, enten som tekst farvet svarende til baggrunden, i en usynlig div eller placeret uden for skærmen. En anden metode giver en anden side afhængigt af, om siden efterspørges af en menneskelig besøgende eller en søgemaskine, en teknik kendt som tilsløring . En anden kategori, der undertiden bruges, er grå hat SEO . Dette er i mellem sort hat og hvid hat tilgange, hvor de anvendte metoder undgår, at webstedet straffes, men ikke handler om at producere det bedste indhold til brugerne. Grå hat SEO er helt fokuseret på at forbedre søgemaskinernes placeringer.

Søgemaskiner kan straffe websteder, de opdager ved hjælp af sorte eller grå hat -metoder, enten ved at reducere deres placeringer eller helt fjerne deres fortegnelser fra deres databaser. Sådanne sanktioner kan enten anvendes automatisk af søgemaskinernes algoritmer eller ved en manuel gennemgang af webstedet. Et eksempel var Google -fjernelsen af både BMW Tyskland og Ricoh Tyskland i februar 2006 til brug for vildledende praksis. Begge virksomheder undskyldte dog hurtigt, fikset de krænkende sider og blev gendannet til Googles søgemaskiners resultatside.

Som marketingstrategi

SEO er ikke en passende strategi for hvert websted, og andre internetmarkedsføringsstrategier kan være mere effektive, f.eks. Betalt annoncering via pay -per -klik -kampagner (PPC) , afhængigt af webstedsoperatørens mål. Søgemaskine marketing (SEM) er praksis med at designe, køre og optimere søgemaskine annoncekampagner. Dens forskel fra SEO er mest enkelt afbildet som forskellen mellem betalt og ulønnet prioritetsrangering i søgeresultater. SEM fokuserer på fremtrædelse mere end relevans; webstedsudviklere bør betragte SEM med den største betydning med hensyn til synlighed, da de fleste navigerer til de primære fortegnelser for deres søgning. En vellykket internetmarketingkampagne kan også afhænge af at opbygge websider af høj kvalitet til at engagere og overtale internetbrugere, oprette analyseprogrammer for at sætte webstedsejere i stand til at måle resultater og forbedre et websteds konverteringsfrekvens . I november 2015 offentliggjorde Google en fuld 160-siders version af sine retningslinjer for søgekvalitetsbedømmelse for offentligheden, hvilket afslørede et skift i deres fokus mod "nytteværdi" og mobil lokal søgning . I de senere år er mobilmarkedet eksploderet og overhalet brugen af desktops, som det fremgår af StatCounter i oktober 2016, hvor de analyserede 2,5 millioner websteder og fandt ud af, at 51,3% af siderne blev indlæst af en mobilenhed. Google har været en af de virksomheder, der udnytter populariteten af mobilbrug ved at tilskynde websteder til at bruge deres Google Search Console , den mobilvenlige test, som giver virksomheder mulighed for at måle deres websted til søgemaskinens resultater og bestemme, hvor brugervenligt det er deres hjemmesider er. Jo tættere nøgleordene er sammen, vil deres rangering blive forbedret baseret på nøgleord.

SEO kan generere et tilstrækkeligt afkast af investeringen . Søgemaskiner får dog ikke betalt for organisk søgetrafik, deres algoritmer ændres, og der er ingen garantier for fortsatte henvisninger. På grund af denne mangel på garanti og usikkerheden kan en virksomhed, der er meget afhængig af søgemaskine trafik, lide store tab, hvis søgemaskinerne holder op med at sende besøgende. Søgemaskiner kan ændre deres algoritmer, hvilket påvirker et websteds søgemaskineplacering, hvilket muligvis kan resultere i et alvorligt tab af trafik. Ifølge Googles administrerende direktør, Eric Schmidt, foretog Google i 2010 over 500 algoritmændringer - næsten 1,5 om dagen. Det betragtes som en klog forretningspraksis for webstedsoperatører at befri sig fra afhængighed af søgemaskinetrafik. Ud over tilgængelighed med hensyn til webcrawlere (adresseret ovenfor) er brugerwebtilgængelighed blevet stadig vigtigere for SEO.

Internationale markeder

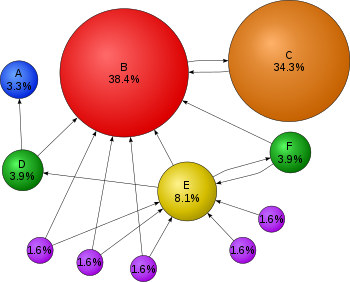

Optimeringsteknikker er meget afstemt efter de dominerende søgemaskiner på målmarkedet. Søgemaskinernes markedsandele varierer fra marked til marked, det samme gør konkurrencen. I 2003 udtalte Danny Sullivan , at Google repræsenterede omkring 75% af alle søgninger. På markeder uden for USA er Googles andel ofte større, og Google er fortsat den dominerende søgemaskine på verdensplan fra 2007. Fra 2006 havde Google en markedsandel på 85–90% i Tyskland. Mens der på det tidspunkt var hundredvis af SEO -firmaer i USA, var der kun omkring fem i Tyskland. I juni 2008 var Googles markedsandel i Storbritannien tæt på 90% ifølge Hitwise . Denne markedsandel opnås i en række lande.

Fra 2009 er der kun få store markeder, hvor Google ikke er den førende søgemaskine. I de fleste tilfælde, når Google ikke er førende på et givet marked, halter det efter en lokal spiller. De mest markante eksempelmarkeder er Kina, Japan, Sydkorea, Rusland og Tjekkiet, hvor henholdsvis Baidu , Yahoo! Japan , Naver , Yandex og Seznam er markedsledende.

Vellykket søgeoptimering til internationale markeder kan kræve professionel oversættelse af websider, registrering af et domænenavn med et topdomæne på målmarkedet og webhosting, der giver en lokal IP -adresse . Ellers er de grundlæggende elementer i søgeoptimering i det væsentlige de samme, uanset sprog.

Juridiske præcedenser

Den 17. oktober 2002 anlagde SearchKing sag ved United States District Court , Western District of Oklahoma, mod søgemaskinen Google. SearchKings påstand var, at Googles taktik til at forhindre spamdeksering udgjorde en torturisk indblanding i kontraktforhold. Den 27. maj 2003 gav domstolen Googles forslag om at afvise klagen, fordi SearchKing "undlod at angive et krav, som der kan ydes fritagelse for."

I marts 2006 anlagde KinderStart en retssag mod Google for rangeringer af søgemaskiner. KinderStarts websted blev fjernet fra Googles indeks før retssagen, og trafikmængden til webstedet faldt med 70%. Den 16. marts 2007 afviste United States District Court for Northern District of California ( San Jose Division) KinderStarts klage uden tilladelse til at ændre, og delvist godkendte Googles forslag til regel 11 -sanktioner mod KinderStarts advokat, hvor han skulle betale en del af Googles advokatudgifter.

Se også

- Blognetværk

- Liste over søgemaskiner

- Søgemaskine marketing

- Søgneutralitet , det modsatte af søgemanipulation

- Brugerens hensigt

- Promovering af websted

Noter

eksterne links

- Promotion for webudvikling hos Curlie

- Retningslinjer for webmastere fra Google

- Retningslinjer for kvalitetsvurderingsværdier for Google -søgning (PDF)

- Webmasterressourcer fra Yahoo!

- Retningslinjer for webmastere fra Microsoft Bing

- The Dirty Little Secrets of Search i The New York Times (12. februar 2011)

- Google I/O 2010 - Rådgivning om SEO -websted fra eksperterne på YouTube - Teknisk vejledning om søgemaskineoptimering, givet på Google I/O 2010